短期間で日本のスタートアップシーンを大きく揺るがした超大型スタートアップの「メルカリ」が、Kaggle(Kaggleとは?)にて競争コンペを公開しました!

私が記憶している限りだと、おそらく「リクルート」に次いで、日系企業として2社目かと思います!日本勢カグラーで上位を叩き出したいところではありますが、ひとまず最速レビューとして英語の苦手な方でも参加が可能なように、コンペの概要をまとめました。

また、ランダムフォレストを使って、既に複数のカーネル(コード)も公開されていましたので、機械学習初心者向けのハンズオンチュートリアルもまとめています。機械学習を勉強されている方は、これを機会にKaggleへの参加をしてみてはいかがでしょうか?

初めて機械学習に学ぶのであれば、Kaggleへ参加する前に初歩的な手法から学ぶのがオススメです。環境構築が不要、オンラインで実行が可能な機械学習入門チュートリアルを公開中!機械学習の世界へ飛び込んでみませんか?

この記事の目次 [隠す]

メルカリ 価格予測チャレンジ概要

Kaggleメルカリチャレンジでは、販売者が投稿した情報を基に「適正な販売価格」を予測するチャレンジです。訓練データとして、ユーザーが投稿した商品情報やカテゴリ、さらに商品の状態やブランド名などが与えられており、それらを基に販売価格を予測するモデル作成が課題です!

下記、Kaggleメルカリチャレンジの必要な概要情報まとめです。

- コンペ開始日は2017年11月21日

- エントリー締切日は2018年2月7日

- 課題提出締切日は2018年2月14日

- このチャレンジは「カーネルオンリー」(カーネルの提出をしないと評価されません)

- 現在公開されているデータ(Stage1)のカーネルを使ってStage2のデータ予測を行う

- チャレンジの最終ランキングはStage2のスコアが基準となる

- 賞金は1位60,000米ドル、2位30,000米ドル、3位10,000米ドル

まだ公開されて4日目と間もないですが、既に231チームが参加しています。現時点でのトップスコアは「0.44408」ですが、時間が経つにつれてスコアは改善されるかと!公開ランキングでは、既に日本人らしきお名前も数名見かけます!(頑張りましょう!!)

では、早速データの簡単な概要と、ランダムフォレストを使った初心者向けKaggleメルカリのハンズオンチュートリアルをやっていきましょう。

Kaggleメルカリ初心者向けチュートリアル概要

本チュートリアルは、機械学習初心者向けの内容となっています。既にKaggleへ参加しているデータサイエンティストの皆々様からは厳しいツッコミがありそうですが・・暖かい目で見守ってください。(笑)

チュートリアルで使うもの

- Python 3.X

- Pandas

- Numpy

- scikit-learn

- Jupyter Notebook(必須ではありません)

Python 2をお使いの方がいましたら、3を使うようにお願いします。それ以外のライブラリは、おそらくバージョンが多少違くても問題ないかと思います。

チュートリアルで行う内容

- Kaggleメルカリチャレンジのデータの確認

- データ事前処理

- ランダムフォレストのモデル作成

- 予測データのCSV書き出し

- Kaggleへの投稿

メルカリチャレンジの「Kernels」ページでは既にたくさんのランダムフォレストを使った予測モデルが公開されています。本チュートリアルでは、同様にランダムフォレストを使った予測を行います。Kaggleメルカリチャレンジへ投稿(Submit)すると「0.53」のスコアとなります。(11月25日時点で100位以内/231位)

参考までにですが、本チュートリアルはMac macOS High Sierra、メモリ 8GB、プロセッサ2.4GHz Core i5で、15分〜20分程度で処理が完了しました。

Kaggleメルカリのデータ確認

では、早速やってみましょう。まずは必要なものをインポートしておきましょう。

次にメルカリから提供されているトレーニングとテストデータを読み込みましょう。Kaggle Mercari Price Suggestion Challenge Dataのページからダウンロードが可能です。ダウンロードにはKaggleへの無料会員登録とコンペ参加規約への同意が必要ですので、まだ会員でない方は、まずはKaggleへの登録をしましょう。

メルカリから提供されているデータ形式ですが、「.7z」の形式となっています。Macをお使いの方は、「The Unarchiver」 で解凍が可能です。(無料でApp Storeより入手可能)

Kaggleからデータをダウンロードして解凍が出来たら、Pandasでデータフレームへ読み込みを行いましょう。

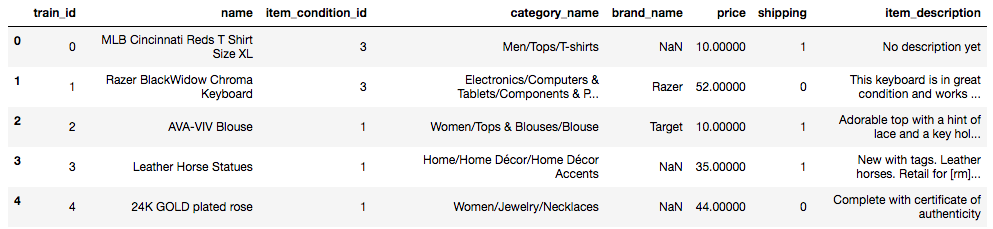

お決まりですが、ひとまずheadとshapeでデータのサイズと中身をチラ見してみましょう。

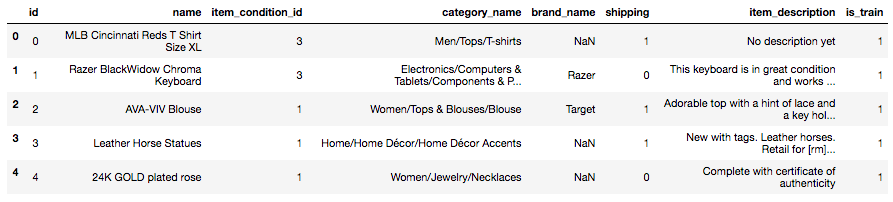

trainの最初5行

testの最初5行

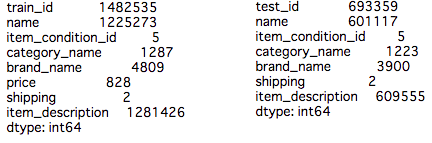

トレーニングデータは1,482,535個のユーザーが投稿した販売商品のデータセットとなっています。同様にテストデータは693,359個となりますが、「価格(Price)」の項目がテストデータは含まれていませんので列数は「8」となっています。

各データの情報を簡単にまとめました。

- train_id / test _id – ユーザー投稿のID

- name – 投稿のタイトル。タイトルに価格に関する情報がある場合(例:$20)はメルカリが事前に削除をして[rm]と置き換えています。

- item_condition_id – ユーザーが指定した商品の状態

- category_name – 投稿カテゴリー

- brand_name – ブランドの名前

- price – 訓練データのみ。実際に売られた価格。米ドル表示。今回のチャレンジの予測ターゲットとなります。

- shipping – 送料のフラグ。「1」は販売者負担。「0」は購入者負担。

- item_description – ユーザーが投稿した商品説明の全文。タイトルと同様に価格情報がある場合は[rm]と置き換えられています。

冒頭でも触れましたが、Kaggleメルカリチャレンジではこのダウンロードしたデータは「ステージ1」のデータとなります。実際にランキングの評価となるテストデータは、メルカリが新たに提供する「ステージ2」のデータです。(締切日までに投稿されたカーネルに自動的にステージ2のテストデータが提供されてスコアが算出されます)

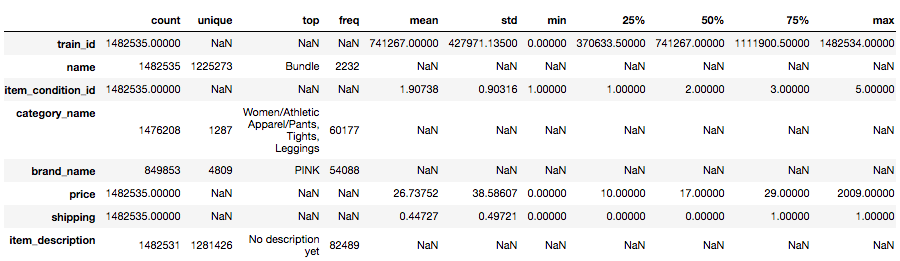

次にデータの統計量を確認しましょう。Pandasの行と列の表示オプションを最大にして表示する「display_all」を作成して、trainとtestの統計量を確認します。「transpose」で列と行を転置しています。

ふむふむ。「item_description」の「Top」では「No description yet」と出ていますね。商品説明がしっかり入っている訳ではなさそうですね。価格(price)は平均(mean)が26.74ドルで標準偏差(std)が38.59ドル。最小値が0ドル、最大値は2009ドルとなっています。一体、メルカリで2009ドルもの高価なものが売れているのに驚きが隠せませんが、それよりも最小値0ドルも気になります。

あんまり深追いすると進みませんので、サクサクと次にいきましょう!

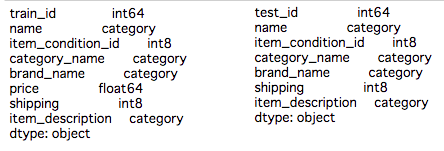

次は、下記の4つの文字列を値として持っている項目を「category」のデータタイプへ変換をしましょう。

データタイプを文字列からcategoryへ変換する項目(trainとtestで同項目)

- category_name

- item_description

- name

- brand_name

左がtranで右がtestです。指定した項目のデータ形式が「category」に変換されているのが確認できます。

次はデータのユニーク値を確認しておきましょう。

左がtrainで右がtestのユニーク値の確認テーブル

当然ではありますが、train、test共にIDはしっかりとユニークな値となっています。カテゴリやブランド名の重複は当然ですが、投稿タイトル(name)にも重複データが結構ありますね。先に確認しましたが商品説明では「No Description yet」(商品説明がまだありません)があったので、こちらも重複があって当然ですね。

モデルを作成する前に必ずやらなくてはいけない作業、欠損データの確認もしておきましょう!

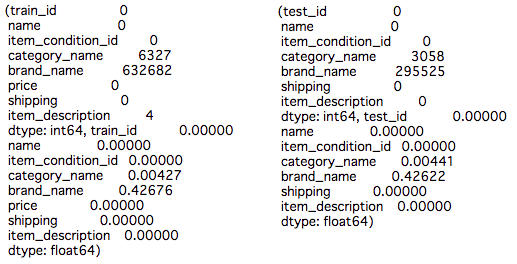

左がtrainで右がtestです。最初に欠損データ数を表示して、次に欠損データの割合を表示しています

カテゴリ名(category_name)とブランド名(brand_name)は欠損数が大きいですね。ブランド名の欠損度合いはかなり大きいのも確認できます。データの簡単な確認も行えましたので、次からはデータの事前処理を行なっていきましょう。

Kaggleメルカリ データ事前処理

さて、ランダムフォレストのモデルを作成するためにデータの事前処理を行なっていきましょう。事前処理の流れとしては・・

- trainとtestのデータを連結させる

- 連結させたDataFrameの文字列のデータ形式を「cateogry」へ変換

- 文字列を数値へ値を変換

- 訓練用データの「price」をnp.log()で処理

- ランダムフォレスト用にxとy(ターゲット)で分ける

ランダムフォレストのモデルを作るため、文字列のデータ(例:投稿タイトルやカテゴリ名など)をPandasの関数を使って一気に数値へと変換させます。そのため、testとtrainで別々に処理を行わず、連結して事前処理を行います。

文字列を数値へ変換したら、testとtrainへ改めて分けて、さらにランダムフォレスト作成のため、trainからターゲット(つまりprice)を分ける処理を行います。

文章で見ると・・いまいちパッとしませんので、実際にコードを見ていきましょう!

まずは、trainとtestのIDのカラム名を変更して、さらにデータ連結後でもどちらのデータに属しているかわかるようにフラグをつけておきましょう。

これで、trainとtestのデータの連結が「train_test_combine」に入りました。念のためshapeを確認すると「(2175894, 8)」と訓練データ1,482,535個とテストデータ693,359個の合計になっているのが確認できます。

次は、文字列のデータを数値へ変換しましょう。先に「train」と「test」を個別に文字列データの形式をcategoryに変換しましたが、同様に、連結させたデータ(train_test_combine)のデータ形式も変更をしましょう。

category形式に変換したら、pandasのcat.codesで数値へ変換を行います。

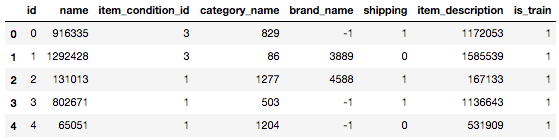

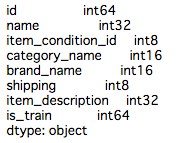

train_test_combineのヘッド情報

train_test_combineのdtypes

しっかりと文字列の値が数値へ変換されていますね。念のため表示したdtypesでも、objectからintへ変換されているのが確認できます。

数値へ変換が行えましたので、ここでtestとtrainへまた分けましょう。「is_train」(trainとtestのどちらに属するかを示すフラグ)は不要なので、この段階で落として、念のため、分け終わった後のtrain、testのデータフレームのサイズを確認しておきましょう。

さて、とうとう次でデータ事前処理の最後のステップとなります!無事に文字列→数値へ変換ができましたので、「df_train」(訓練データ)へ「train」の価格(price)を戻して、log関数で処理を行いましょう。

カテゴリ名(category_name)や投稿タイトル(name)などがしっかりと数値に変換されているのが確認できます。参考までにですが、上記のheadのデータのbrand_nameでも確認できますが、文字列から数値へcat.codesへ変換した際に、異常値は「-1」として戻ります。

非常にシンプルなものですが、これでデータセットの事前処理は終わりました!次は、いよいよランダムフォレストのモデルをこのデータを使って作成していきましょう。

ランダムフォレストのモデル作成

もうここまで来れば、(気持ち的に)予測が完了したも同然です笑。では、処理をしたデータを使って、scikit-learnのRandomForestRegressorでモデルを作りましょう!

(処理完了までMac macOS High Sierra、メモリ 8GB、プロセッサ2.4GHz Core i5で、15分〜20分程度かかりました)

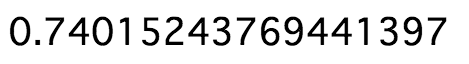

さぁ・・・・気になるスコアは・・・

となりました(笑)

モデルも作れましたので、先に処理を指定た「df_test」(テスト用データ)を入れて、実際の予測値を出しましょう。

予測値が出たら、指数関数(np.exp())で処理をして、Pandasシリーズへ落とし込み、メルカリチャレンジの予測提出ファイル形式へ処理をしてCSVの書き出しを行いましょう!

自分のパソコンで処理を行なっていた方であれば、「submit_rf_base.csv」のファイルが書き出しされているかと思います。

今回のKaggleメルカリコンペですが、カーネルでのみ評価提出が可能なので、もしKaggleへ実際に投稿してみたい方は、Kaggleのカーネルへ上記コードを入れて提出をしましょう!

冒頭でもお話をしましたが、こちらの処理でスコア「0.53」となります。(11月25日時点で100位以内/231位)

まとめ

いかがでしたでしょうか?すでにKaggleメルカリチャレンジへ参加しているチームは日に日に増えており、さらに上位スコアも伸びてきています!

codexaでは日本でのカグラーのマッチングも行なっています!もし一人で参加するより、チームに参加して挑戦してみたいとお考えの方は、お問い合わせにてKaggleの公開プロフィールURLを記載してご連絡ください!スキルレベルが同等のメンバー様とマッチングいたします。

まだ機械学習を始めたばかりの方は、Kaggleタイタニックのチュートリアルもやってみてはいかがでしょうか?今回はランダムフォレストを使用しましたが、タイタニックでは「決定木」を使っています。

も間違いなどがありましたら・・コメント欄にてご指導・ご指摘をお願い致します!

へー…

kernelなんて、初心者に優しいものがあるんだね

これやってみよ

それにしても0.53ですか

世に出回るAIはすごいんですねぇ…